How To Know The Robots TXT Used By The Blog : Pada kesempatan ini saya akan memberikan kepada Anda salah satu cara untuk mengetahui struktur Robots.txt yang digunakan oleh para master web/blogger. Dari hasil pengalaman saya yang selama ini seraba penasaran, karena begitu banyaknya tutorial tentang robots.txt berhamburan di google dengan cara-cara yang berbeda pula, sehingga sayapun bingung harus memilih yang mana untuk digunakan. Bayangkan saja waktu saya pertama kali mengenal dunia blogging saya tidak begitu mementing hal ini karena menurut yang pernah saya baca bahwa robots.txt fungsingnya untuk membatasi halaman yang akan diindeks. Karena dengan minimnya pengalaman saya didunia blogging pada waktu itu maka saya berpendapat "kenapa harus dibatasi...? udah susah-susah buat artikel kok dibatasi". Akhirnya setelah membuat beberapa artikel ternyata di search engine banyak terdapat Duplikat Conten, Duplikat Tag dsb.

Seperti yang saya katakan diatas begitu banyaknya tutorial mengenai robots.txt sayapun mencoba menggunakan salah satu cara yang dari sebagian tutorial yang ada karena saya lihat bentuknya sama akhir saya ambil dan memsangnya pada blog untuk menghindari duplikat dan alhasil artikel hilangkan begitu saya ditelan bumi dari mesin pencarian. Setalah diteliti ternyata terletak pada Robots.txt sempat membuat saya pusing harus berbuat apa, saya coba hapus kembali robot.txt yang terpasang toh hasilnya tetap saja artikel tidak muncul di mesin pencarian.

Dengan berjalannya waktu saya mencoba berselancar kembali di google untuk mencari solusi terbaik untuk menghilangkan Duplikat. Ahkirnya saya mencoba melihat artikel2 yang terpajang dimesin pencarian dan menemukan salah satu situs yang tidak mengalami duplikat walaupun mengalami mungkin tidak sebanyak Blog saya sebelumnya. Sayapun penasaran seperti apa robots.txt yang digunakannya...? Nah disini saya akan memberikan caranya.

1. Pertama ketik website mana yang telah lama nongkrong di search engine

2. Kemudian copy URL tersebut dan paste di Menu Bar browser dengan ekstensi seperti ini

3. Maka Anda akan melihat robots.txt yang digunakannya.

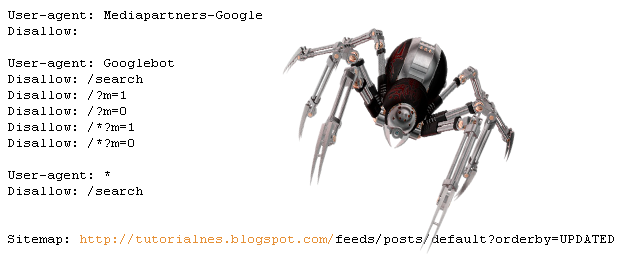

Karena banyaknya pengguna template Responsive saat ini atau versi seluler, maka saya menggunakan robots.txt seperti ini

Keterangan:

Robots.txt ini untuk mengatasi duplikat konten yang terjadi karena halaman versi seluler.

Pengertian Robots.txt

Robots.txt adalah Sebuah file dengan fungsi untuk membatasi akses robot mesin pencari yang sedang menjelajahi situs web . Sebelum mereka mengakses halaman web, mereka memeriksa untuk melihat apakah sebuah file robots.txt ada / tidak , dan di dalam robots.txt ada perintah yang mencegah mereka mengakses halaman tertentu.

Seperti yang saya katakan diatas begitu banyaknya tutorial mengenai robots.txt sayapun mencoba menggunakan salah satu cara yang dari sebagian tutorial yang ada karena saya lihat bentuknya sama akhir saya ambil dan memsangnya pada blog untuk menghindari duplikat dan alhasil artikel hilangkan begitu saya ditelan bumi dari mesin pencarian. Setalah diteliti ternyata terletak pada Robots.txt sempat membuat saya pusing harus berbuat apa, saya coba hapus kembali robot.txt yang terpasang toh hasilnya tetap saja artikel tidak muncul di mesin pencarian.

Dengan berjalannya waktu saya mencoba berselancar kembali di google untuk mencari solusi terbaik untuk menghilangkan Duplikat. Ahkirnya saya mencoba melihat artikel2 yang terpajang dimesin pencarian dan menemukan salah satu situs yang tidak mengalami duplikat walaupun mengalami mungkin tidak sebanyak Blog saya sebelumnya. Sayapun penasaran seperti apa robots.txt yang digunakannya...? Nah disini saya akan memberikan caranya.

Ikuti Tutorial Berikut:

1. Pertama ketik website mana yang telah lama nongkrong di search engine

2. Kemudian copy URL tersebut dan paste di Menu Bar browser dengan ekstensi seperti ini

http://tutorialnes.blogspot.com/robots.txt3. Maka Anda akan melihat robots.txt yang digunakannya.

Karena banyaknya pengguna template Responsive saat ini atau versi seluler, maka saya menggunakan robots.txt seperti ini

User-agent: Mediapartners-Google

Disallow:

User-agent: Googlebot

Disallow: /search

Disallow: /?m=1

Disallow: /?m=0

Disallow: /*?m=1

Disallow: /*?m=0

User-agent: *

Disallow: /search

Sitemap: http://tutorialnes.blogspot.com/feeds/posts/default?orderby=UPDATEDKeterangan:

Robots.txt ini untuk mengatasi duplikat konten yang terjadi karena halaman versi seluler.

Click here for comments 0 komentar:

Dilarang menambahkan link aktif ataupun meng-iklankan suatu produk dll.

Komentar yang tidak bertanggung jawab menggunakan anonim akan segera dihapus.